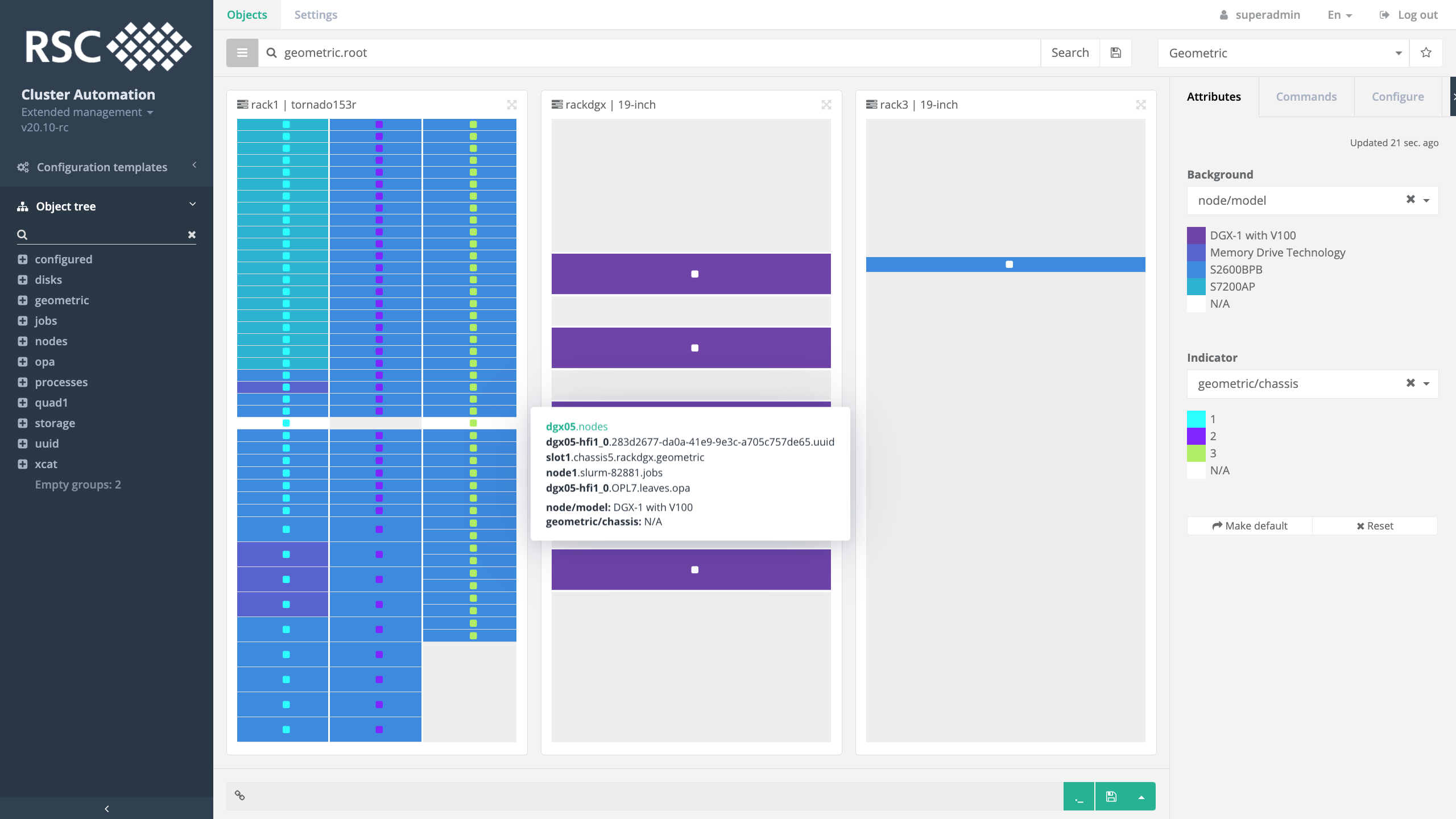

Объединенный институт ядерных исследований (ОИЯИ) г. Дубна

«Говорун» в ОИЯИ – первый в мире гиперконвергентный суперкомпьютер со 100% жидкостным охлаждением.

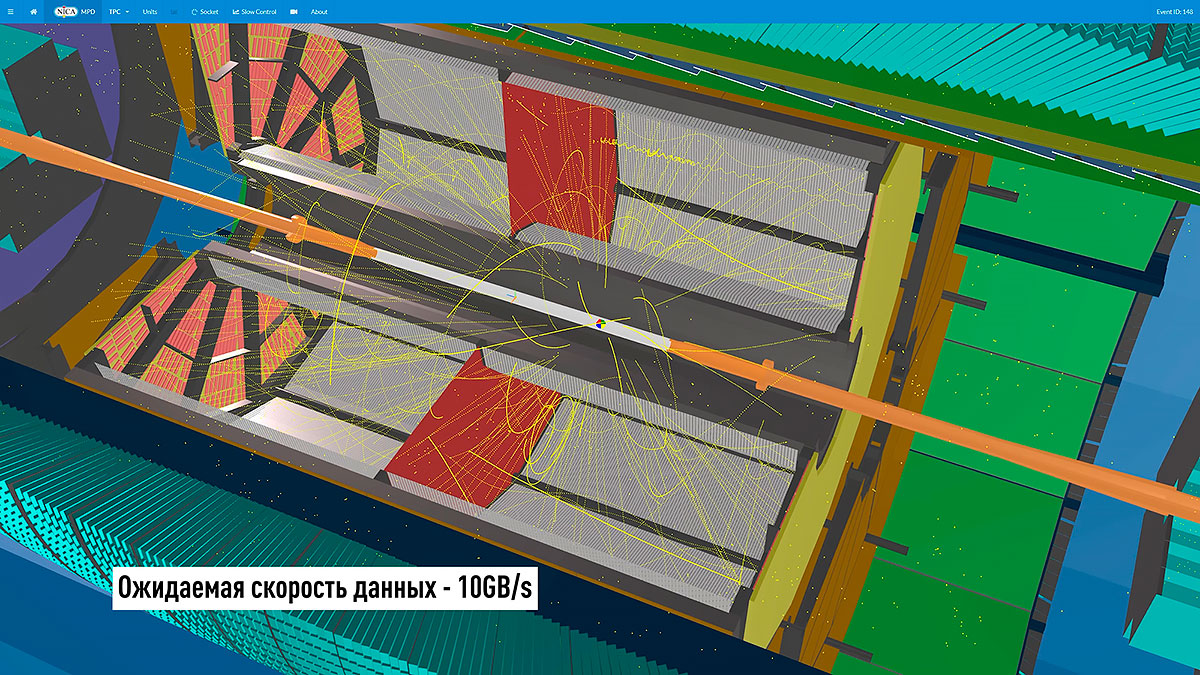

Проект нацелен на кардинальное ускорение комплексных теоретических и экспериментальных исследований в области физики высоких энергий, ядерной физики и физики конденсированных сред, проводимых в Объединенном институте ядерных исследований (ОИЯИ), в том числе для реализации мегапроекта NICA

Распределённая система хранения «по требованию»

Применение гиперконвергентного подхода позволило создать для суперкомпьютера Говорун уникальную высокоскоростную систему хранения данных РСК Storage-on-Demand, обладающую лидерскими характеристиками – общая скорость параллельной файловой системы на чтение/запись информации превышает 300 ГБ/с, что является рекордом не только на территории России/СНГ, но и на территории Европы.

Система занимает 22-е место в текущей редакции списка IO500 (ноябрь 2020 г.), нового индустриального рейтинга для систем хранения данных HPC-класса.

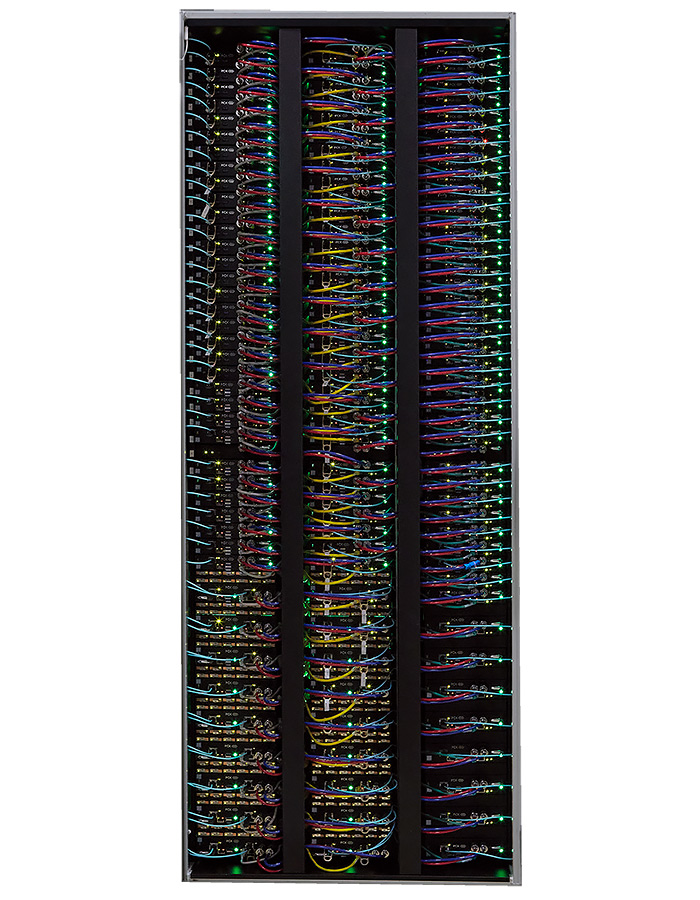

Сервера РСК Торнадо как вычислительный ресурс и распределённая СХД

Сервера «РСК Торнадо» TDN511, TDN511S и TDN551 AFS с прямым жидкостным охлаждением хорошо сбалансированы как для применения в решении самых различных вычислительных задач, так и для использования в составе системы хранения данных РСК Storage-on-Demand, формируемой «по требованию» на базе различных файловых систем.

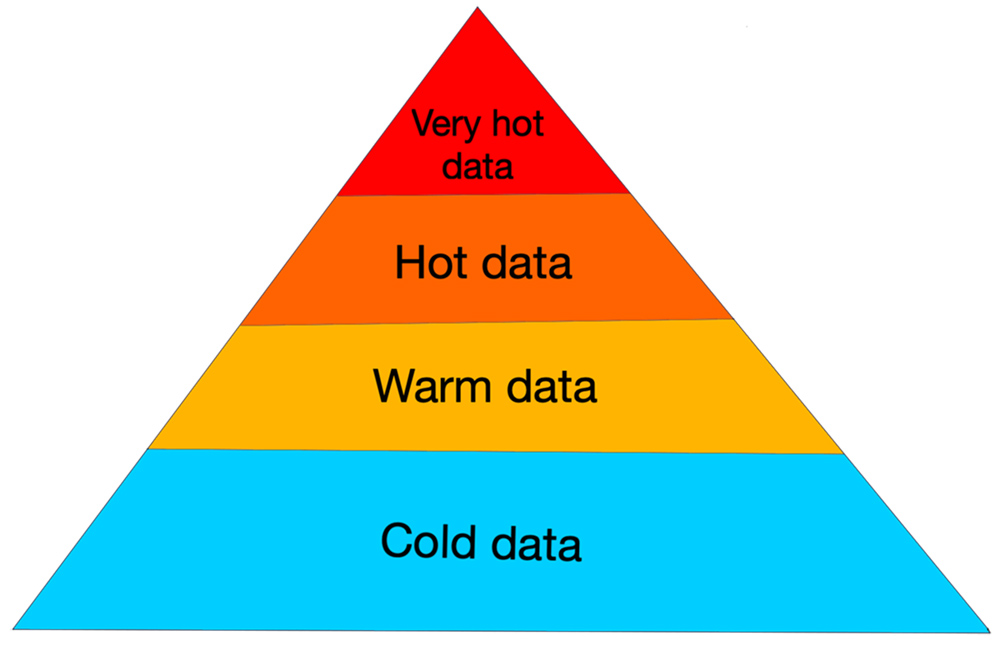

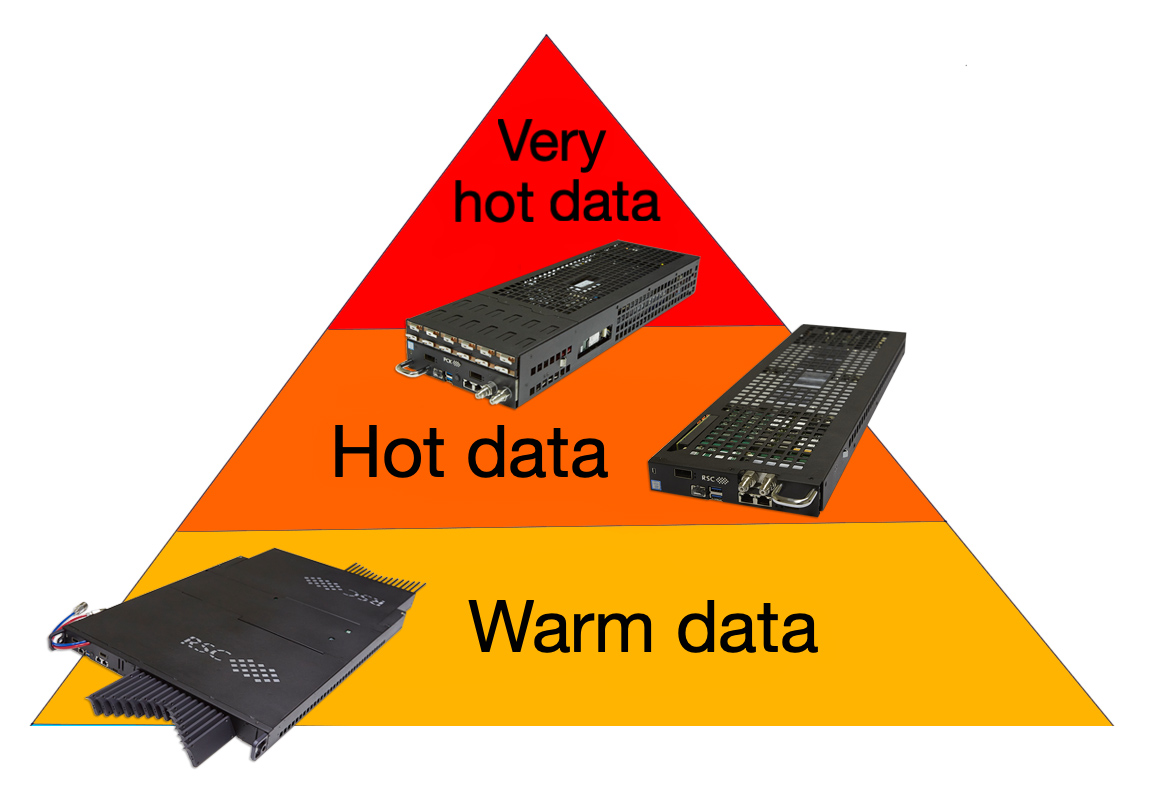

Распределённая система хранения представляет собой единую централизованно управляемую систему и имеет несколько уровней хранения данных - очень горячие данные, горячие данные и тёплые данные.

Система хранения очень горячих данных создана на основе четырёх серверов-лезвий РСК Торнадо TDN511S. В каждый сервер установлено 12 высокоскоростных твёрдотельных дисков с низкой латентностью Intel® Optane™ SSD DC P4801X 375GB M.2 Series с технологией Intel® Memory Drive Technology (IMDT), что позволяет получить 4,2 ТБ для очень горячих данных на каждом сервере.

Система хранения горячих данных состоит из статической системы хранения с параллельной файловой системой Lustre, созданной на основе 14 серверов-лезвий РСК Торнадо TDN511S, и динамической РСК Storage-on-Demand на 84 серверах-лезвиях РСК Торнадо TDN511 с поддержкой параллельной файловой системы Lustre и распределенной объектной системы хранения DAOS. Для быстрого доступа к метаданным файловой системы Lustre без задержек используются твёрдотельные диски с низкой латентностью Intel® Optane™ SSD DC P4801X 375GB M.2 Series, а для тех же целей в DAOS используется Intel® Optane™ Persistent Memory. Для хранения горячих данных Lustre и DAOS используются твердотельные диски Intel® SSD DC P4511 (NVMe, M.2).

Система хранения тёплых данных создана на основе сервера РСК Торнадо TDN551 AFS, который содержит до 32 твердотельных дисков форм-фактора EDSFF E1.L Intel® SSD DC P4326 объёмом 15,36 Терабайт каждый. Это позволяет получить 491,5 Терабайт для хранения данных всего в 1U стоечного пространства. По мере появления на рынке твердотельных дисков более высокой плотности объём увеличится до 1 Петабайта в 1U и выше.

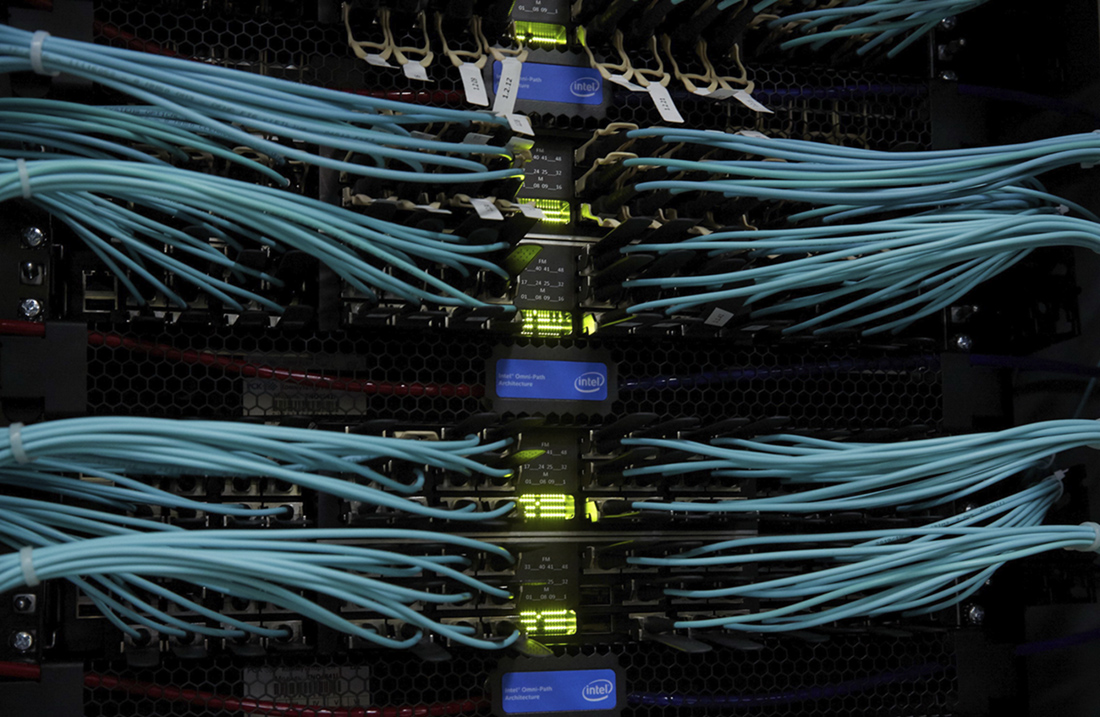

Высокоскоростная сеть Intel Omni-Path

Для высокоскоростной передачи данных между вычислительными узлами в составе суперкомпьютерного комплекса ОИЯИ используется технология коммутации Intel® Omni-Path, обеспечивающая скорость неблокируемой коммутации до 100 Гбит/c, на основе 48-портовых коммутаторов Intel® Omni-Path Edge Switch 100 Series со 100% жидкостным охлаждением, что обеспечивает высокую эффективность работы системы охлаждения в режиме «горячая вода» и наиболее низкую совокупную стоимость владения системой. Характеристики низколатентной Intel® Omni-Path Architecture позволяет удовлетворить не только текущие потребности ресурсоемких приложений пользователей, но и обеспечить необходимый запас пропускной способности для распределенных систем хранения суперкомпьютера.

Энергоэффективное решение

Использование технологий жидкостного охлаждения РСК и модуля охлаждения RSC CDU-HM 400 в режиме «горячая вода» дало возможность работать в режиме free cooling круглый год (24x7x365), используя только сухие градирни, работающие при температуре окружающего воздуха до +50 °C, а также полностью избавиться от фреонового контура и чиллеров. В результате среднегодовой показатель PUE системы, отражающий уровень эффективности использования электроэнергии, составляет менее чем 1,06. То есть на охлаждение расходуется менее 6% всего потребляемого электричества, что является выдающимся результатом для HPC-индустрии.