Компании АО «Карма Групп» и ЗАО «РСК Технологии» заключили соглашение о партнерстве и продвижении на отечественном рынке внешнего массива PCIe-коммутации RSC ScaleStream-C на базе GPU/TPU-ускорителей. Статус партнера позволяет «Карма Групп» предлагать своим клиентам инновационные российские вычислительные платформы разработки и производства РСК, созданные специально для расширения возможностей в области систем искусственного интеллекта (ИИ) и машинного обучения.

Группа компаний РСК является ведущим в России и СНГ разработчиком и интегратором энергоэффективных, высокоплотных и масштабируемых систем с прямым жидкостным охлаждением, предназначенных для высокопроизводительных вычислений (HPC), машинного и глубокого обучения (ML/DL), центров обработки данных, периферийных вычислений (Edge Computing), а также для интеллектуальных систем хранения данных по требованию.

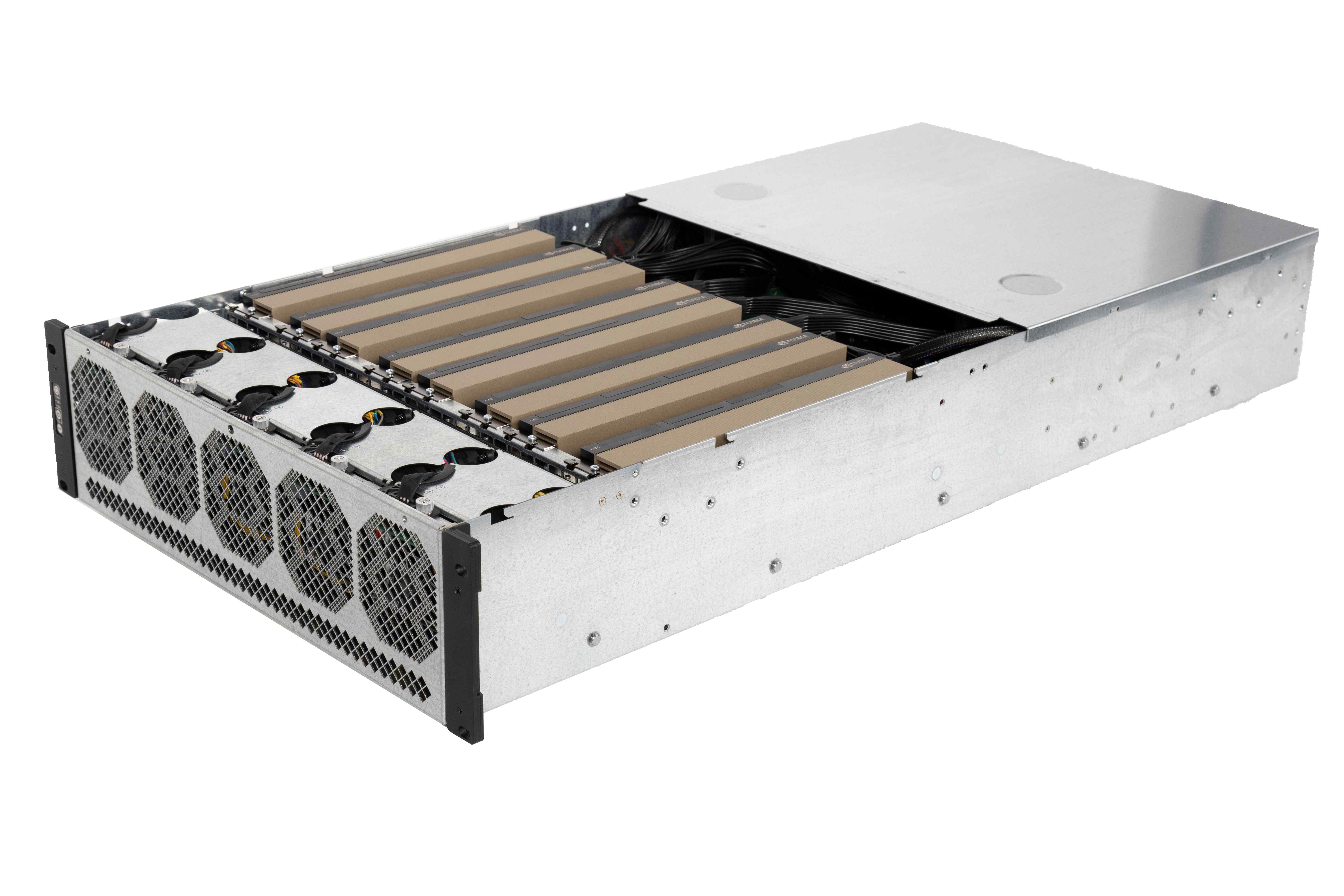

RSC ScaleStream-C — масштабируемые и гибкие массивы GPU/TPU-карт для поддержки ресурсоемких нагрузок

Новым продуктом в портфеле РСК является система RSC ScaleStream-C. Это внешний массив PCIe-ускорителей, который спроектирован для интеграции самых мощных GPU/TPU-карт и служит для расширения вычислительного потенциала серверов при решении сложных задач в сферах HPC, машинного обучения и искусственного интеллекта.

RSC ScaleStream-C (JBOG) представляет собой внешний массив GPU/TPU-ускорителей, оснащенный коммутатором. Конструкция массива поддерживает установку до 10-ти PCIe x16 ускорителей, допуская использование карт различной ширины и их объединение, а также подключение до четырех серверов посредством внешних кабелей, использующих стандарт PCIe x16 Gen4.

Решение RSC ScaleStream-C (JBOG) демонстрирует высочайшую производительность, достигая до 300 Терафлопс (FP64) в конфигурации с десятью картами NVIDIA H200 и до 960 TOPS (int8) на массив с десятью картами LinQ HPQ разработки российской компании «ХайТэк».

Ключевым преимуществом решения RSC ScaleStream-C является возможность формирования программно-определяемых конфигураций ресурсов GPU и серверов. Ускорители могут динамически перераспределяться между подключенными серверами в реальном времени без остановки системы. Эта особенность открывает уникальные перспективы для формирования конфигураций под конкретные вычислительные нагрузки, что особенно ценно при развертывании облачных инфраструктур. Благодаря такому динамическому перераспределению, коэффициент использования GPU может быть значительно повышен — в отдельных случаях на десятки процентов — по сравнению с традиционными серверами с ускорителями.